En el vertiginoso mundo de la Inteligencia Artificial, cada nuevo lanzamiento promete revolucionar el campo, pero pocos logran cumplir verdaderamente esa promesa. Sin embargo, DeepSeek V3 está demostrando ser la excepción a la regla, estableciendo nuevos estándares en el ecosistema de modelos Open Source.

Un rendimiento que habla por sí mismo

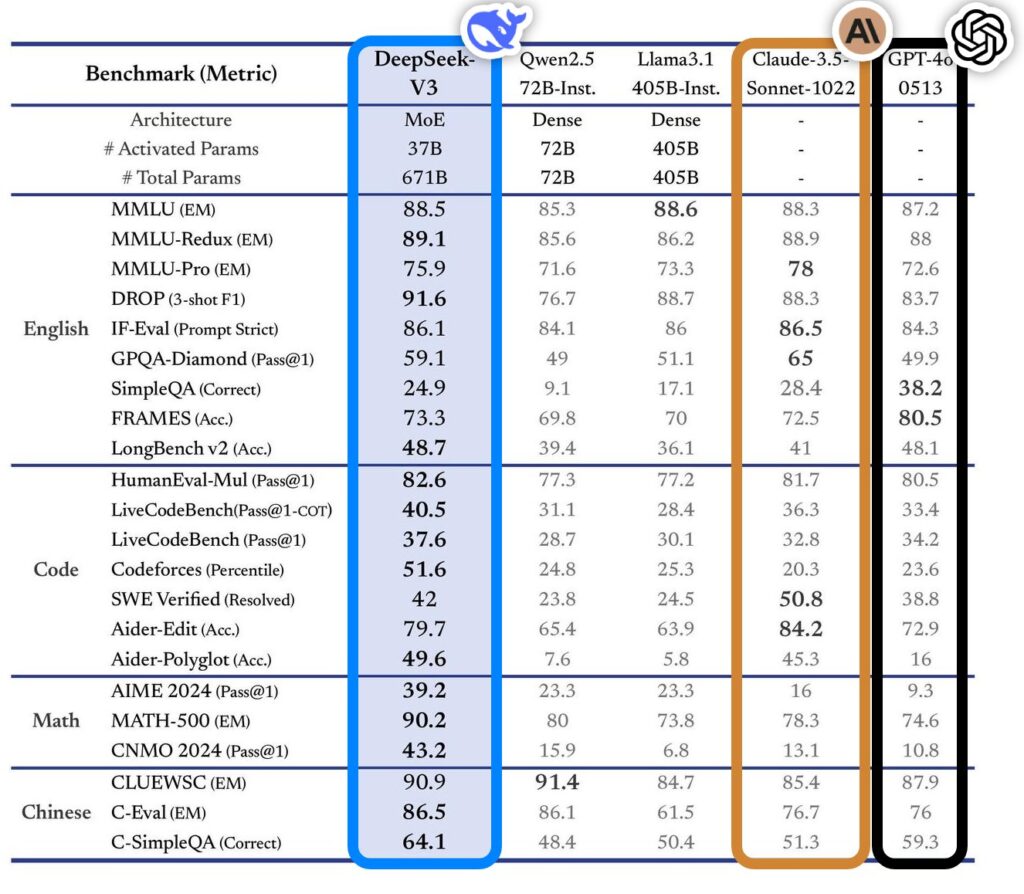

Los números son contundentes: DeepSeek V3 no solo compite, sino que supera a modelos establecidos en múltiples benchmarks. Con una arquitectura MoE (Mixture of Experts) y 671B de parámetros totales, sus resultados son especialmente impresionantes en tareas de codificación y matemáticas, donde tradicionalmente los modelos open source han mostrado limitaciones.

Algunos resultados destacables:

- 91.6% en DROP (Discrete Reasoning Over Paragraphs). Es una prueba que evalúa la capacidad del modelo para realizar razonamiento matemático y lógico sobre textos. El impresionante 91.6% en la métrica F1 con solo 3 ejemplos (3-shot) demuestra una excelente capacidad de comprensión y razonamiento, superando incluso a modelos propietarios como Claude y GPT-4o.

- 90.2% en MATH-500. Evalúa la capacidad del modelo para resolver problemas matemáticos complejos de nivel universitario.

- 82.6% en HumanEval-Mul. Es una variante del conocido benchmark HumanEval que evalúa la capacidad de generación de código. La prueba presenta problemas de programación que requieren implementar funciones basadas en descripciones en lenguaje natural

- 79.7% en Aider-Edit. Este benchmark evalúa la capacidad del modelo para editar y modificar código existente.

Accesibilidad sin comprometer el rendimiento

Una de las barreras tradicionales para el uso de modelos de gran escala ha sido la necesidad de infraestructura robusta. DeepSeek V3 soluciona este problema ofreciendo una API con un pricing competitivo:

- 0.27$ por millón de tokens de entrada

- 1.10$ por millón de tokens de salida

Si bien estos precios son ligeramente superiores a alternativas como Gemini 1.5 Pro (a través de VertexAI), la relación calidad-precio sigue siendo excepcional considerando su rendimiento.

El cierre de la brecha

Estamos presenciando un momento histórico en el desarrollo de la IA: la diferencia de rendimiento entre modelos open source y propietarios se está reduciendo significativamente. Esta tendencia, que ya observamos con Llama 3.2 y Qwen, se consolida con DeepSeek V3, sugiriendo un futuro donde la democratización de la IA de alto rendimiento sea una realidad.

Implicaciones para el futuro

El éxito de DeepSeek V3 no es solo una victoria para la comunidad open source, sino un indicador claro de hacia dónde se dirige el campo de la IA. La combinación de accesibilidad, rendimiento y transparencia está sentando las bases para una nueva era en el desarrollo de aplicaciones basadas en IA.

Conclusión

DeepSeek V3 representa un hito significativo en la evolución de los modelos de lenguaje open source. Su capacidad para competir y superar a modelos propietarios, junto con su accesibilidad a través de API, lo convierte en una opción muy atractiva tanto para desarrolladores individuales como para empresas.

¿Quieres ver cómo puedes comenzar a utilizar DeepSeek V3 en tus propios proyectos? Te invito a explorar mi próximo tutorial donde mostraremos paso a paso cómo implementar este potente modelo.

Deja una respuesta