Cuando los científicos de datos trabajamos con nuestros modelos de Inteligencia Artificial necesitamos alguna forma de poder medir el rendimiento de estos. ¿Cómo sabemos si hemos construido un buen o mal modelo?

En el artículo de hoy te voy a explicar un concepto muy básico: la matriz de confusión y cómo esta nos ayuda en problemas clásicos de Machine Learning a medir el rendimiento de nuestros modelos.

¿Qué es una Matriz de Confusión?

Imagina que has creado un modelo para detectar correos spam. Tu modelo analiza miles de correos y debe decidir si cada uno es spam o no. La matriz de confusión es simplemente una tabla que nos muestra cuántas veces nuestro modelo acertó y cuántas se equivocó, pero de una manera muy específica y útil.

Estructura de la Matriz de Confusión

Para entender mejor la matriz de confusión, vamos a usar un ejemplo sencillo con nuestro detector de spam:

Predicción: Spam | Predicción: No Spam

Real: Spam VP (50) | FN (10)

Real: No Spam FP (5) | VN (935)

Donde:

- VP (Verdaderos Positivos): Correos que son spam y nuestro modelo identificó correctamente como spam.

- VN (Verdaderos Negativos): Correos legítimos que nuestro modelo identificó correctamente como no spam.

- FP (Falsos Positivos): Correos legítimos que nuestro modelo identificó incorrectamente como spam.

- FN (Falsos Negativos): Correos spam que nuestro modelo no detectó.

Errores Tipo I y Tipo II: Los Falsos Positivos y Falsos Negativos

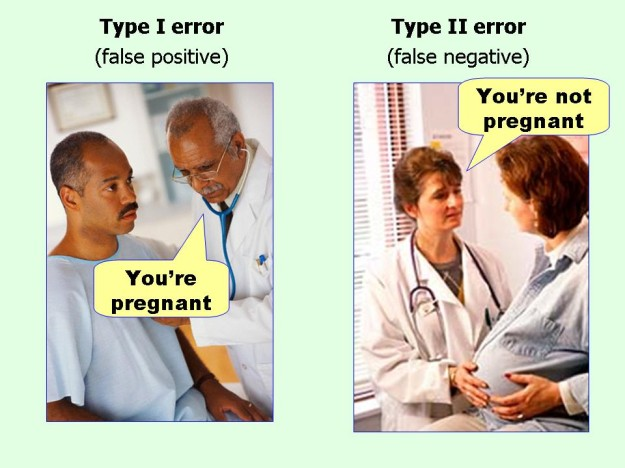

Para entender mejor los errores en nuestras predicciones, es fundamental conocer los conceptos de Error Tipo I y Error Tipo II. Y para hacerlo más memorable, vamos a usar un ejemplo que, aunque humorístico, ilustra perfectamente estos conceptos.

Error Tipo I (Falso Positivo)

Imagina un doctor diciéndole a un paciente masculino «Estás embarazado». Esto es claramente un error, ¿verdad? Este es un ejemplo perfecto de un Error Tipo I:

- Es un falso positivo

- Estamos afirmando que algo es verdadero cuando en realidad es falso

- En términos estadísticos, estamos rechazando incorrectamente la hipótesis nula

- En nuestro ejemplo del spam, sería marcar un correo legítimo como spam

Error Tipo II (Falso Negativo)

Ahora imagina a una doctora diciéndole a una paciente visiblemente embarazada «No estás embarazada». Este es un Error Tipo II:

- Es un falso negativo

- Estamos afirmando que algo es falso cuando en realidad es verdadero

- En términos estadísticos, estamos aceptando incorrectamente la hipótesis nula

- En nuestro ejemplo del spam, sería no detectar un correo que realmente es spam

¿Por qué es tan importante?

La matriz de confusión nos permite calcular métricas cruciales para evaluar nuestro modelo:

- Precisión (Accuracy): ¿Qué porcentaje de predicciones son correctas en total?

- Fórmula: (VP + VN) / (VP + VN + FP + FN)

- Sensibilidad (Recall): Del spam real, ¿cuánto detectamos correctamente?

- Fórmula: VP / (VP + FN)

- Especificidad: De los correos legítimos, ¿cuántos identificamos correctamente?

- Fórmula: VN / (VN + FP)

- Precisión (Precision): Cuando decimos que algo es spam, ¿qué tan seguros estamos?

- Fórmula: VP / (VP + FP)

Interpretación en el Mundo Real

La importancia de cada métrica dependerá de tu caso de uso específico. Por ejemplo:

En diagnóstico médico, querríamos minimizar los falsos negativos, ya que no detectar una enfermedad puede ser muy grave.

En detección de spam, quizás preferimos tener algunos falsos positivos (correos legítimos marcados como spam) que dejar pasar spam peligroso.

El Trade-off entre Precision y Recall

Uno de los conceptos más importantes al trabajar con matrices de confusión es entender que existe un compromiso inevitable entre precision y recall. Este compromiso es conocido como el «precision-recall trade-off».

Imagina que ajustamos nuestro modelo de detección de spam para que sea extremadamente estricto: solo marcará un correo como spam cuando esté «super seguro». ¿Qué sucederá?

- Alta Precision: Cuando marquemos algo como spam, casi nunca nos equivocaremos.

- Bajo Recall: Pero dejaremos pasar mucho spam sin detectar.

Por el contrario, si hacemos nuestro modelo muy sensible:

- Alta Recall: Detectaremos casi todo el spam existente.

- Baja Precision: Pero marcaremos muchos correos legítimos como spam por error.

Consejos para Mejorar tu Modelo

La matriz de confusión no solo nos ayuda a evaluar nuestro modelo, sino que también nos da pistas sobre cómo mejorarlo:

- Si tienes muchos falsos positivos, tu modelo es demasiado «sensible» y necesitas ajustar sus parámetros para hacerlo más restrictivo.

- Si tienes muchos falsos negativos, tu modelo es demasiado «conservador» y necesitas hacerlo más sensible.

- Si tienes problemas en ambas categorías, podrías necesitar más datos de entrenamiento o características más relevantes.

Conclusión

La matriz de confusión es una herramienta fundamental en el arsenal de cualquier científico de datos. Nos permite entender de manera clara y precisa cómo se está comportando nuestro modelo y nos guía hacia posibles mejoras. Aunque parezca simple a primera vista, la información que nos proporciona es invaluable para construir modelos más precisos y confiables.

Deja una respuesta